Instagram ha annunciato di avere iniziato ad implementare una nuova funzionalità che avvisa gli utenti quando cio’ che scrivono nella didascalia di una foto o un video che stanno per pubblicare puo’ essere considerato offensivo, con la possibilità di riconsiderare le parole usate prima di pubblicare. C’è una intelligenza artificiale sviluppata e già testata dalla società dietro questo strumento di analisi, che è in grado di riconoscere diverse forme di bullismo su Instagram.

Questa nuova funzione fa parte del piu’ grande impegno preso da Instagram a lungo termine nella lotta contro il bullismo online.

Instagram per combattere il bullismo online lancia due nuovi strumenti

https://www.pianetacellulare.it/Articoli/Social-Network/49213_Instagram-per-combattere-il-bullismo-online-lancia-due-nuovi.php

All’inizio di quest’anno, Instagram ha lanciato una funzione che avvisa gli utenti della sua community quando i loro commenti potrebbero essere considerati offensivi prima che vengano pubblicati. Dai risultati ottenuti in questi mesi, Instagram ha concluso che questa funzione è utile poichè le persone sono propense a riconsiderare le loro parole quando ne viene data loro la possibilità.

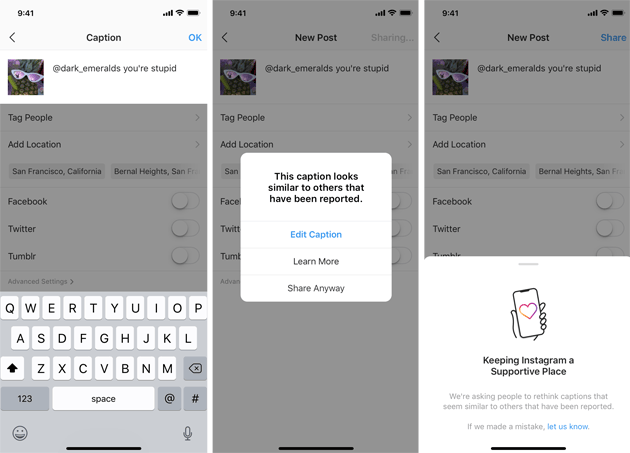

Ecco cosa cambia da oggi: mentre si sta scrivendo una didascalia per un post da pubblicare su Instagram se l’IA rileva che quanto scritto è potenzialmente offensivo mostrerà un messaggio che informa che si sta scrivendo qualcosa di già segnalato come bullismo, dando la possibilità di modificarlo prima di procedere con la pubblicazione.

Oltre a limitare il cyber-bullismo all’interno di Instagram, questa funzione dovrebbe educare le persone su ciò che è consentito condividere su Instagram e informare su quanto un account potrebbe essere a rischio di violare le regole della community.

Instagram ha iniziato il 16 dicembre 2019 a rendere disponibile questa nuova funzione in determinati Paesi ma sarà portata a livello globale nel corso del 2020.

Esempio di messaggio da Instagram che informa di una didascalia con testo potenzialmente offensivo