Il secondo giorno della F8 2019, la annuale conferenza di Facebook per gli sviluppatori, si è concentrato sugli investimenti a lungo termine che la società sta realizzando in Intelligenza Artificiale, Realtà Virtuale/Aumentata. Nel keynote di apertura, il Chief Technology Officer Mike Schroepfer ha parlato degli strumenti di intelligenza artificiale che si stanno utilizzando per affrontare una serie di sfide tra i prodotti della società e perché è ottimista su ciò che verrà. Schroepfer è stato seguito da Manohar Paluri e Joaquin Quinonero Candela di Facebook AI, Margaret Stewart del Product Design, Lade Obamehinti, Lindsay Young e Ronald Mallet che si occupano di AR/VR.

INTELLIGENZA ARTIFICIALE NEI PRODOTTI FACEBOOK.

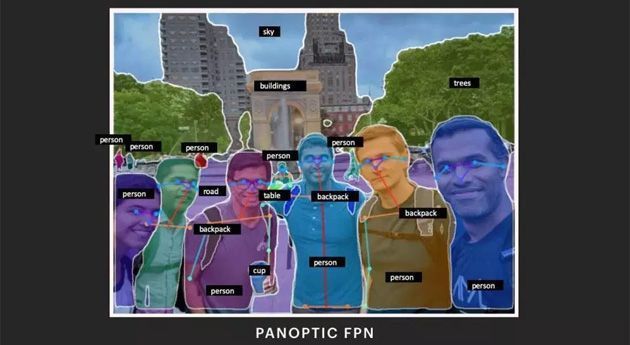

L’Intelligenza Artificiale alimenta una vasta gamma di prodotti su Facebook. Negli ultimi anni, l’IA è stata usata per rilevare in modo proattivo i contenuti condivisi dagli utenti che violano le politiche del social media. Per aiutare a rilevare più di questi contenuti problematici, Facebook è al lavoro per assicurarsi che i suoi sistemi di intelligenza artificiale possano comprendere i contenuti con la minima supervisione possibile. E sono stati fatti progressi negli ultimi anni, ma Facebook è consapevole di avere ancora molta strada da fare. I progressi nell’elaborazione della lingua naturale (NLP) hanno aiutato a creare un linguaggio digitale comune per le traduzioni, in modo da poter rilevare contenuti dannosi in più lingue. E un nuovo approccio al riconoscimento degli oggetti chiamato Panoptic FPN ha aiutato i sistemi basati su IA a comprendere il contesto dallo sfondo delle foto. I modelli di allenamento che combinano segnali visivi e audio migliorano ulteriormente i risultati. Il lavoro sull’elaborazione del linguaggio naturale è importante, ma molte tecniche funzionano meglio per le lingue più comuni. Facebook ha detto di avere bisogno di un modo per supportare le molte lingue in cui non ci sono abbastanza campioni su cui allenare il sistema. L’apprendimento auto-supervisionato può essere d’aiuto poiché vi è la possibilità di addestrare modelli per nuove lingue senza che l’essere umano etichetti set di dati aggiuntivi per quelle nuove lingue. Questo consente una migliore comprensione dei contenuti pertinenti, incluse le violazioni delle norme, senza dover tradurre ogni frase. L’intelligenza artificiale è utile ma comporta anche dei rischi, ad esempio può riflettere e amplificare i pregiudizi. Per risolvere questo problema, Facebook è al lavoro per creare best practice per l’equità, per garantire che l’IA protegga le persone e non le discrimini in ogni fase dello sviluppo del prodotto.

Quando i modelli di intelligenza artificiale sono addestrati dall’uomo su set di dati che coinvolgono persone, esiste cio’ che Facebook ha definito un "rischio rappresentazionale intrinseco". Se i set di dati contengono limitazioni, difetti o altri problemi, i modelli risultanti potrebbero avere prestazioni diverse per persone diverse. Per gestire tale rischio, Facebook ha sviluppato un nuovo processo per l’IA inclusiva, un processo che fornisce linee guida per aiutare ricercatori e programmatori a progettare set di dati, misurare le prestazioni del prodotto e testare nuovi sistemi attraverso l’obiettivo dell’inclusività. Per la parte visiva, tali dimensioni includono il colore della pelle, l’età e il genere mentre per la parte vocale includono dialetto, età e sesso. L’IA inclusiva è ora in uso per molti prodotti di Facebook e integrata nello sviluppo di nuove funzionalità.

Facebook F8 2019: AR/VR

AR/VR

Una delle aree in cui Facebook sta utilizzando il processo di intelligenza artificiale inclusiva è la realtà aumentata (AR). Gli ingegneri di Spark AR la utilizzano per garantire che il loro software offra effetti AR di qualità per tutti. Ad esempio, alcuni degli effetti sono attivati ​​da un gesto della mano, quindi i dati di allenamento includevano varie tonalità del colore della pelle in una varietà di condizioni di illuminazione per garantire che il sistema riconoscesse una mano davanti alla telecamera. Gli ingegneri di Oculus stanno anche utilizzando questo processo per i comandi vocali nella realtà virtuale (VR), utilizzando dati rappresentativi attraverso dialetti, età e sesso.

Mentre si lavora per garantire che la tecnologia non escluda le persone, Facebook sta anche lavorando per assicurarsi che aiuti a riunire le persone. E con la realtà virtuale, la società si immagina un futuro in cui le persone possono interagire indipendentemente dalla distanza fisica. Ma per raggiungere davvero questo obiettivo, le persone hanno bisogno di sentirsi completamente presenti nella realtà virtuale. Ciò significa che servono avatar realistici, con gesti, espressioni facciali e tono di voce che aggiungano sfumature alle conversazioni.

Facebook è arrivata a sviluppare un realismo rivoluzionario nei volti con Codec Avatars per consentire alle persone di interagire in tempo reale in VR ma un’autentica comunicazione richiede la partecipazione di tutto il corpo. Ecco perché la società sta sviluppando modelli completamente adattivi basati sulla fisica che riproducono un avatar 3D con dati provenienti da un numero limitato di sensori e sta anche utilizzando un approccio a livelli che replica l’anatomia umana e può adattarsi automaticamente per adattarsi perfettamente all’aspetto e al movimento unici di ogni individuo. Facebook sta progettando questi modelli dall’interno verso l’esterno, sviluppando prima uno scheletro virtuale che poi prende forma a strati, aggiungendo poi la struttura muscolare, la pelle e l’abbigliamento. Il risultato sono avatar realistici in tutta la forma del corpo. C’è ancora molta strada da fare prima che questa tecnologia si traduca in un prodotto, quindi non si sa tra quanto sarà disponibile pubblicamente.

Quando Facebook ha rilasciato le sue prime app di social VR, tra cui Spaces, Venues e Rooms, ha incorporato una sicurezza di base dell’esperienza. Un video di orientamento puo’ introdurre le persone ad alcune delle funzionalità progettate per farle sentire più a loro agio a interagire con un grande gruppo di persone mentre sono in un ambiente virtuale. Ad esempio, la ‘safety bubble’ è una funzione che impedisce alle persone o agli oggetti di avvicinarsi più di quanto desiderano. Se un avatar entra nella ‘bolla di sicurezza’ di un altro, entrambi gli avatar diventano invisibili l’uno all’altro. Sono inoltre attivi dei moderatori ‘reali’ per garantire comportamenti adeguati e rivedere i rapporti di comportamento inappropriati.

Gli strumenti e i processi che Facebook ha condiviso a F8 2019 fanno parte di come i team della società si stanno preparando per ciò che verrà piu’ avanti: "Per noi, questo lavoro riguarda il portare voce e opportunità alle persone di tutto il mondo e aiutare le persone a rimanere in contatto tra loro".