Quando Google ha introdotto il suo motore di Ricerca venti anni fa i risultati che Ricerca mostrava erano semplici, poi qualcosa è cambiato il 24 febbraio 2000, come ha spiegato nel blog di BigG il Director of Engineering di Google Images, Cathy Edwards, ricordando che il giorno dopo i Grammy Awards di quell’anno il team dietro il motore di ricerca ha notato che le persone stavano cercando di tutto e di piu’ circa l’abito verde indossato da Jennifer Lopez all’evento. In quel momento Google si è resa conto che le persone stavano cercando informazioni "visive" e non solo "di testo". Negli anni seguenti, l’aumento dell’utilizzo dei dispositivi mobili con schermi di piccole dimensioni ha reso ancora più importante la scansione rapida dei risultati visivi. Da allora, Google ha lavorato per includere più immagini e video nella sua Ricerca, riuscendoci in parte grazie ai progressi nella visione artificiale, che aiuta ad "estrarre concetti dalle immagini", ha spiegato Edwards. Oggi, gli algoritmi di Google modellano centinaia di milioni di concetti per ogni immagine e video presenti nell’indice. Ad esempio, l’immagine di una tigre potrebbe generare concetti come "felino", "animale" o "gatto grande". Questo consente "l’identificazione di un’immagine osservando i suoi pixel, senza che sia necessario esprimerlo con parole in una pagina". Nel corso degli anni Google per restare al passo con cio’ a cui gli utenti desiderano trovarsi di fronte quando effettuano delle ricerche sul web, indipendentemente dal dispositivo utilizzato, ha apportato una serie di aggiornamenti alle esperienze offerte online, dedicando alla ricerca di contenuti visivi il portale Google Immagini, dove gli utenti possono trovare le informazioni visive di cio’ che stanno cercando, ad esempio quando si trovano a dover acquistare nuovi prodotti, a progettare una stanza o affrontare un progetto fai-da-te. Con questa premessa Google ha introdotto oggi tre importanti cambiamenti nel modo in cui pensa alla ‘ricerca visiva’, tra cui una serie di nuove funzionalità che utilizzano l’intelligenza artificiale per rendere l’esperienza di ricerca più visiva e piacevole agli utenti.

Contenuti visivi immersivi con le storie di AMP

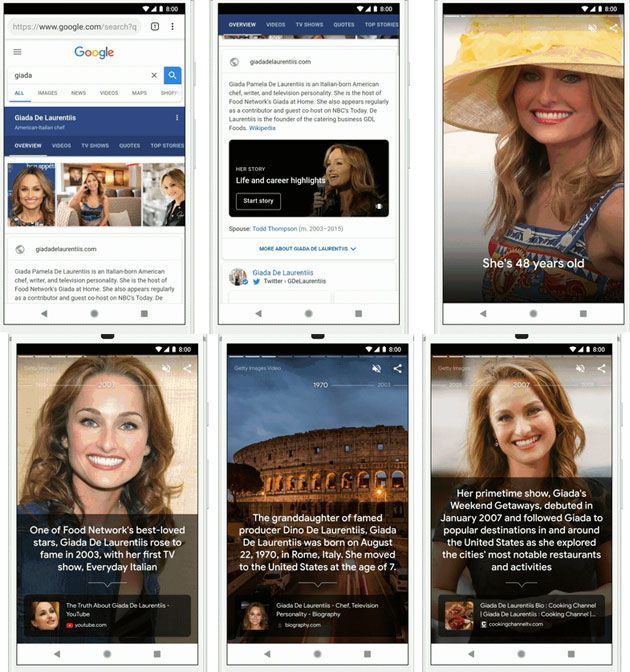

All’inizio di quest’anno Google ha collaborato con AMP Project per annunciare le storie di AMP, una libreria open source che rende facile per chiunque creare una storia sul ‘web aperto’. Mentre è ancora presto per dire che le storie di AMP sono un successo o meno, Google ha notato che molti editori hanno iniziato a sperimentare questo formato per fornire alle persone un modo più visivo per ottenere informazioni da Google Ricerca e Google News. Per aiutare le persone a scoprire queste storie visive, Google mostrerà questi contenuti in Google Immagini e Google Discover (ex Google Feed). Google fa uso dell’intelligenza artificiale per costruire in modo intelligente le storie di AMP e far emergere questo contenuto nella parte alta delle ricerche degli utenti. Si possono già vedere nelle ricerche di personaggi, celebrità e atleti popolari. Le ‘storie di AMP’ forniscono "uno spaccato di fatti e momenti importanti della loro vita in un formato ricco e visivo" ha spiegato Edwards, secondo cui questo formato "consente di toccare facilmente gli articoli per ulteriori informazioni e offre un nuovo modo per scoprire contenuti dal web".

Esempio di contenuto visivo immersivo con storie AMP

Anteprime video di argomenti in primo piano nelle ricerche su Google

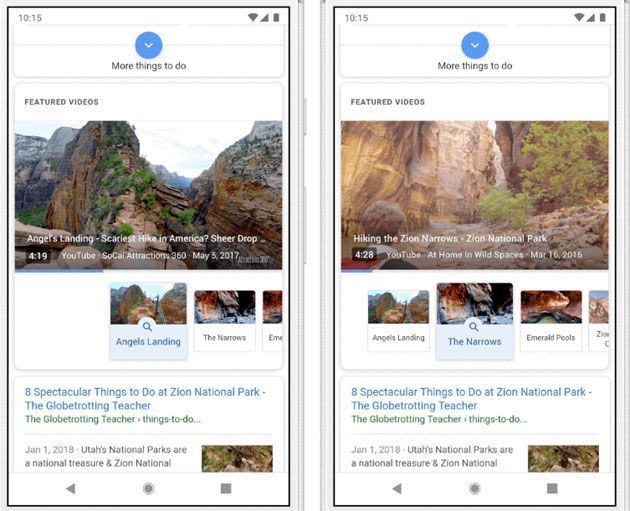

Dal momento che, secondo Google, i video possono essere un modo utile per conoscere nuove cose su determinati argomenti ma può risultare difficile trovare video pertinenti per esplorare tutti i diversi aspetti di un argomento, grazie all’utilizzo della visione artificiale all’interno di Google Ricerca si vedranno nuovi "video in primo piano", ossia delle immagini animate che mostrano l’anteprima visiva di un argomento, e si possono toccare per un approfondimento. Ad esempio, se si vuole pianificare un’escursione ad un parco nazionale in cui non si è mai stati e si desidera guardare video su cosa aspettarsi e idee sui siti da visitare, basta cercare il parco che si visiterà per avere sopra ai risultati della ricerca dei video di anteprima ciascuno su un punto di riferimento specifico che si potrebbe voler aggiungere al piano di viaggio.

"Con i video in primo piano prendiamo la nostra profonda comprensione dello spazio tematico [nell’esempio sopra, i punti di riferimento più importanti nel parco] e mostriamo i video più rilevanti per dei sotto-argomenti" ha spiegato Edwards.

Argomenti con video in primo piano nella ricerca

In Google Immagini arriva piu’ contesto

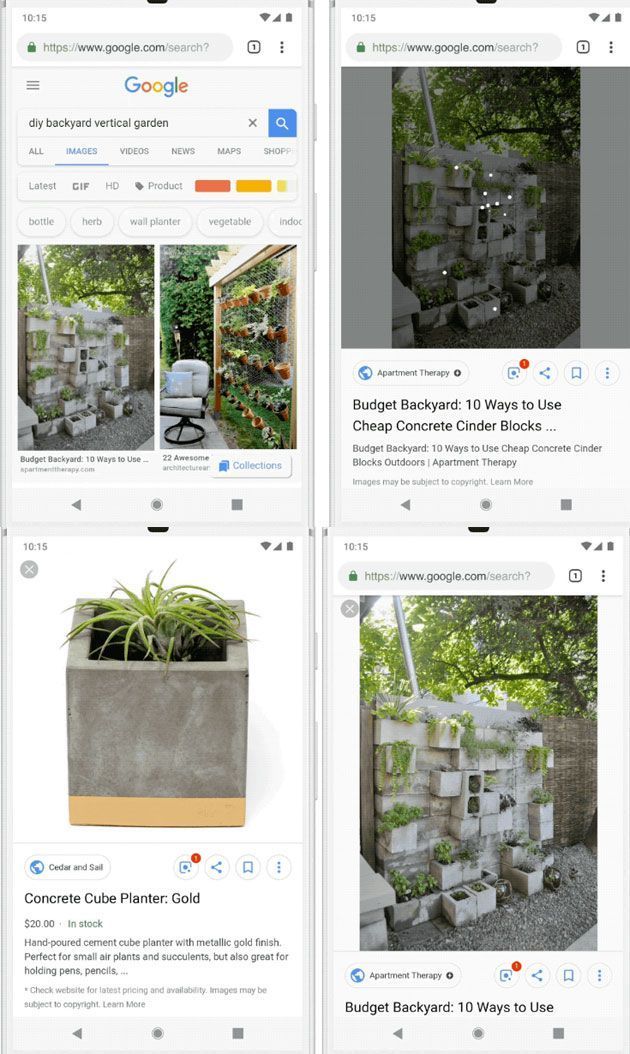

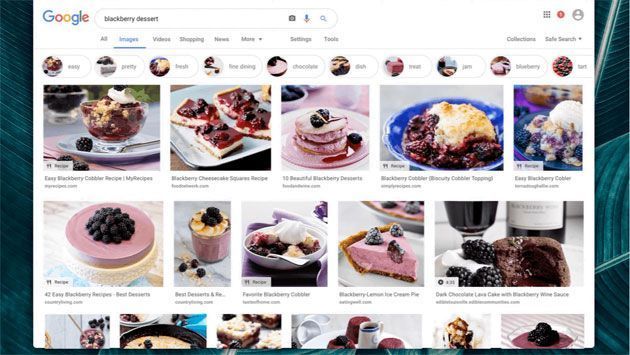

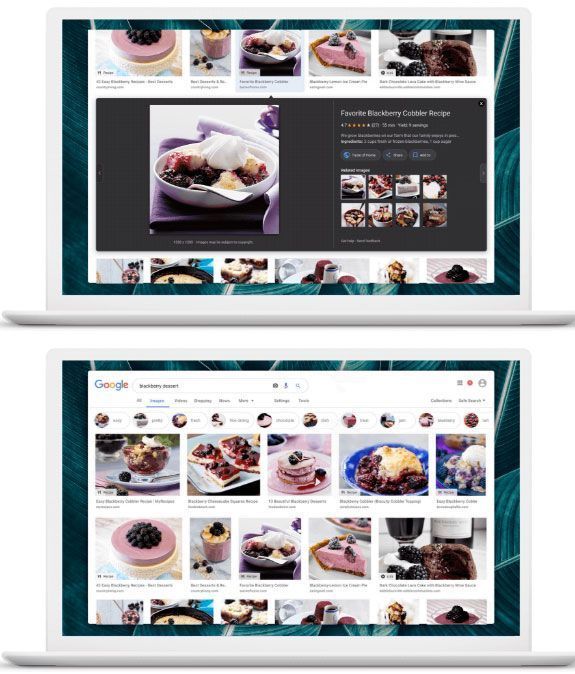

Google ha notato che le persone che arrivano in Google Immagini oggi cercano informazioni o aiuto nel fare qualcosa, non solo per vedere un’immagine. Da qui la decisione di introdurre nuove funzionalità per aiutare gli utenti a trovare più facilmente le informazioni visive e perseguire attività in cui è importante avere un riferimento visivo.

A partire da questa settimana, visitando Google Immagini si vedrà "più contesto intorno alle immagini", tra cui didascalie che mostrano il titolo della pagina web in cui ogni immagine è pubblicata. Google ritiene il contesto importante per aiutare gli utenti a "capire la pagina dietro l’immagine". Inoltre, si vedranno anche termini di ricerca correlati nella parte superiore della pagina, e ciascuno puo’ essere toccato per approfondire l’argomento corrispondente. Questo nuovo design di Google Immagini è stato già introdotto sui dispositivi mobili ed è in arrivo sul desktop.

Il nuovo Google Immagini su desktop

Google Lens in Google Immagini

L’anno scorso Google ha lanciato Google Lens per aiutare gli utenti a fare di più con ciò che si trova in una immagine o cio’ che vede la fotocamera dello smartphone, e sempre piu’ sono le persone che fanno uso di questa tecnologia per trovare oggetti sul web, saperne di più sui punti di riferimento o identificare un animale visto al parco. Nelle prossime settimane Lens arriverà su Google Immagini per aiutare gli utenti ad esplorare e saperne di più sui contenuti visivi che troveranno durante le ricerche. Questo è possibile grazie alla tecnologia di Intelligenza Artificiale di Google che alimenta Lens e analizza le immagini rilevando gli oggetti al loro interno. Selezionando uno degli oggetti rilevati, Lens mostrerà le immagini pertinenti correlate, molte delle quali rimanderanno alle pagine dei prodotti in modo da poter continuare la ricerca o acquistare l’oggetto che interessa.

Google Lens in Google Immagini